一、前傳:

我們在決定分類的時候依據gi(x) = logP(Ci|x)或是P(Ci|x)來決策,其中X是新進來欲分類的資料,Ci則是現有資料的特徵,所以也可以把P(Ci|x)翻譯成:新進來的資料X屬於特徵Ci的機率。

則右圖為分類的取法

而我們也可以把資料表示成另一種形式

w表示權重,x代表樣本,我們把一個class看做一個值也就是等於樣本乘權重,而我們用這個值當作評估的標準,

去調整boundary,ex.假如身高+體重看成一個人身材的評量,如果身高*a+體重*b大於某個值時判定那個人是屬於胖子,

而a和b可以根據我們有的資料做微調也就像是如果我們算出A是胖子,但是A事實上我們認定他不是,那我們就可以把A

也考慮進去,加以調整a和b的權重,也就是調整boundary使得A不是胖子。

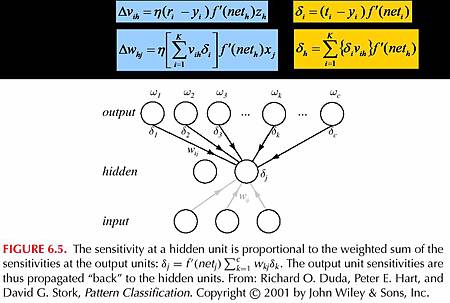

而經過一些推導我們得到這個式子

所以說可以推得如果sigmoid(wTx+w0)>0.5,或是wTx+w0>0則選擇C1

二、 perceptron

上圖是Two-Layer Perceptrons,x0 always=+1,連線部分為weight值,以此例子而言除了(1,1)以外另外三點代入

y=x1+x2-1.5 都小於零,故w0=-1.5可把資料分成兩類,右上代入為正,左下代入為負。

上圖為sigmoid圖,sigmoid常用來做thredshold的功能,由於計算中需要用到微分所以不能直接用binary thredshold

故以sigmoid做取代。

而感知器方程式wTx+w0如果不經過sigmoid算出來的值為線性,常用於regression

但如果是做classification通常都是非線性的boundary,故需要用到sigmoid去做計算。

留言列表

留言列表